Una delle soluzioni più semplici riconosce che i cambiamenti tra probabilità piccole (come 0,1) o i cui complementi sono piccoli (come 0,9) sono solitamente più significativi e meritano più peso rispetto ai cambiamenti tra probabilità medie ( come 0,5).

Ad esempio, una modifica da 0,1 a 0,2 (a) raddoppia la probabilità mentre (b) modifica la probabilità complementare solo di 1/9 (facendola cadere da 1-0,1 = 0,9 a 1 Da -0,2 a 0,8), mentre una variazione da 0,5 a 0,6 (a) aumenta la probabilità solo del 20% mentre (b) diminuisce la probabilità complementare solo del 20%. In molte applicazioni la prima modifica è, o almeno dovrebbe essere, considerata grande quasi il doppio della seconda.

In qualsiasi situazione in cui sarebbe altrettanto significativo usare una probabilità (che qualcosa si verifichi ) o il suo complemento (cioè la probabilità che qualcosa non si verifichi), dobbiamo rispettare questa simmetria.

Queste due idee - di rispettare la simmetria tra le probabilità $ p $ e i loro complementi $ 1- p $ e di esprimere i cambiamenti in modo relativo piuttosto che assoluto - suggerire che quando si confrontano due probabilità $ p $ e $ p '$ dovremmo tenere traccia sia dei loro rapporti $ p' / p $ sia dei rapporti dei loro complementi $ ( 1-p) / (1-p ') $. Quando si tengono traccia dei rapporti è più semplice utilizzare i logaritmi, che convertono i rapporti in differenze. Ergo, un buon modo per esprimere una probabilità $ p $ a questo scopo è usare $$ z = \ log p - \ log (1-p), $$ che è noto come quota di registro o logit di $ p $. Le quote log adattate $ z $ possono sempre essere riconvertite in probabilità invertendo il logit; $$ p = \ exp (z) / (1+ \ exp (z)). $$ L'ultima riga del codice sotto mostra come si fa.

Questo ragionamento è piuttosto generale: porta a una buona procedura iniziale predefinita per esplorare qualsiasi insieme di dati che coinvolge le probabilità. (Sono disponibili metodi migliori, come la regressione di Poisson, quando le probabilità sono basate sull'osservazione di rapporti di "successi" rispetto al numero di "prove", perché le probabilità basate su più prove sono state misurate in modo più affidabile. Non sembra essere il caso qui, in cui le probabilità sono basate su informazioni ottenute. Si potrebbe approssimare l'approccio di regressione di Poisson utilizzando i minimi quadrati ponderati nell'esempio seguente per consentire dati più o meno affidabili.)

Diamo un'occhiata a un esempio.

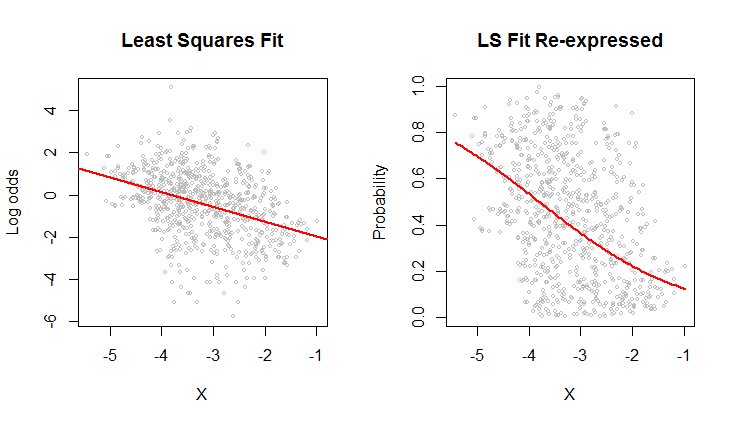

Il grafico a dispersione a sinistra mostra un dataset (simile a quello nella domanda) tracciato in termini di probabilità di log. La linea rossa è la misura dei minimi quadrati ordinari. Ha un $ R ^ 2 $ basso, che indica molta dispersione e una forte "regressione alla media": la retta di regressione ha una pendenza minore dell'asse maggiore di questa nuvola di punti ellittica. Questo è un ambiente familiare; è facile da interpretare e analizzare utilizzando la funzione lm di R o equivalente.

Lo scatterplot a destra esprime i dati in termini di probabilità , come sono stati originariamente registrati. Viene tracciato lo stesso adattamento: ora sembra curvo a causa del modo non lineare in cui le probabilità logaritmiche vengono convertite in probabilità.

Nel senso di errore quadratico medio radice em> in termini di quote logaritmiche, questa curva è la migliore adatta.

Per inciso, la forma approssimativamente ellittica della nuvola a sinistra e il modo in cui traccia la linea dei minimi quadrati suggeriscono che il modello di regressione dei minimi quadrati è ragionevole: i dati possono essere adeguatamente descritti da una relazione lineare-- fornito vengono utilizzate le quote logaritmiche e la variazione verticale attorno alla linea è all'incirca della stessa dimensione indipendentemente dalla posizione orizzontale (omoschedasticità). (Ci sono alcuni valori insolitamente bassi nel mezzo che potrebbero meritare un esame più attento.) Valutalo in modo più dettagliato seguendo il codice seguente con il comando plot (fit) per vedere alcune diagnostiche standard. Questo da solo è un motivo valido per utilizzare le probabilità di log per analizzare questi dati invece delle probabilità.

## Leggi i dati da una tabella di (X, Y) = (X, probabilità) coppie. # x <- read.table ("F: /temp/data.csv", sep = ",", col.names = c ("X", " Y ")) ## Definisce le funzioni per convertire tra probabilità` p` e log odds `z`. # (Quando alcune probabilità effettivamente sono uguali a 0 o 1, un piccolo aggiustamento - dato da un valore # positivo di" e` - deve essere applicato per evitare quote logaritmiche infinite.) # logit <- funzione (p, e = 0) {x <- (p-1/2) * (1-e) + 1/2; log (x) - log (1-x)} logistica <- funzione (z, e = 0) {y <- exp (z) / (1 + exp (z)); (y-1/2) / (1-e) + 1/2} ## Misura le probabilità logaritmiche usando i minimi quadrati. # b <- coef (misura <- lm (logit (x $ Y) ~ x $ X) ) ## Traccia i risultati in due modi. # Par (mfrow = c (1,2)) plot (x $ X, logit (x $ Y), cex = 0.5, col = "Gray", main = "Least Squares Fit ", xlab =" X ", ylab =" Log odds ") abline (b, col =" Red ", lwd = 2) plot (x $ X, x $ Y, cex = 0.5, col =" Gray ", main = "LS Fit Re-espresso", xlab = "X", ylab = "Probability") curva (logistica (b [1] + b [2] * x), col = "Red", lwd = 2, aggiungi = TRUE)